搜索引擎对重复内容的处理办法

发布时间:2022-01-07 13:01 所属栏目:32 来源:互联网

导读:我们使用wordpress的时候经常将文章毫无保留地展示在首页,而不是使用输出摘要(就好像SEMWATCH那样),根据Randfish观察,其实这样子是会搜索引擎误认为内容重复。 究竟URL参数像Session IDs,Tracking IDs是怎样引起内容重复的呢?Googlewebmastercentral

|

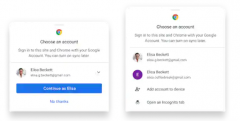

我们使用wordpress的时候经常将文章毫无保留地展示在首页,而不是使用输出摘要(就好像SEMWATCH那样),根据Randfish观察,其实这样子是会搜索引擎误认为内容重复。 究竟URL参数像Session IDs,Tracking IDs是怎样引起内容重复的呢?Googlewebmastercentral (需要翻墙) 透露,同一个产品页面,如果搜索引擎爬虫抓取可以通过多种链接途径抓取同一个产品页面,那样会有以下几种消极的影响: 1.多种URLs会稀释链接的广泛性。比如上图的产品页面,如果有50个导入链接,那有可能分别形成了3种导入URL途径,而不是唯一的某一个URL,这样就等于将导入链接传递的权重分散到3个不同的链接上。 2.搜索结果或许会呈现不友好的URL(比如一大串长长 的session ID,tracking ID)。从而在SERP中,降低了用户对该页面的清晰了解程度(英文url比如semwatch.org/sem,不仅仅具备搜索引擎友好性,更重要的是用户体验友好性),不利于品牌的塑造。 从Search Engine Land给出上图可知,一般来说搜索引擎通过4个步骤来识别内容是原创还是复制: 1.发现。当搜索引擎爬虫发现新的内容,他会立刻与之前收录的内容进行比较确保内容的原创性。 2.丢弃。首先,搜索引擎会放弃收录那些来自链接工厂,MFA站点(Made For Adense)和被列入黑名单的IP的页面 3.解剖。下一步就是分析每个页面的 入站链接,判断链接的质量和源头。 搜索引擎会蜘蛛通过你的某一个特定页面爬行4个或者40个网站上不同的页面,而这种行为一般是通过该页面的相关内容链接进行爬行抓取(比如上图的“滑雪板),很多朋友希望通过将众多页面相互关联起来即使相互之前没有关联性,一个站点的许多页面过度使用同一个关键词,从而为了提高排名。但是事实上,这种行为对于排名是帮助不大的。 (编辑:ASP站长网) |

相关内容

网友评论

推荐文章

热点阅读

苹果开始生产自己的蜂

苹果开始生产自己的蜂 未来的Apple Watch型

未来的Apple Watch型 Google Chrome用户更

Google Chrome用户更 边缘计算2.0:鲲鹏昇

边缘计算2.0:鲲鹏昇 iphone12如何关闭已开

iphone12如何关闭已开